안녕하세요 여러분! 오늘은 정말 꿀팁 하나 가져왔어요. 블로그 상위노출 체크하느라 매번 고생하시는 분들 계시죠? 저도 처음에는 일일이 검색해서 엑셀에 복붙하고… 정말 시간 낭비였어요. 근데 이거 한번 써보시면 진짜 인생이 달라질걸요? 코딩 전혀 모르셔도 괜찮아요! 그냥 복사 붙여넣기만 하면 되니까요. 제가 오늘 소개해드릴 방법으로 업무 효율 200% 올려보세요!

왜 이 자동화 시스템이 필요한가요? 🤔

블로그 상위노출 업무를 하면서 이런 경험 있으신가요? 솔직히 저도 몇 년간 이 일하면서 짜증 많이 났어요.

✅ 시간 낭비: 매주 클라이언트별로 여러 키워드의 순위를 확인하느라 몇 시간씩 소요됩니다. 진짜 손가락 아파요.

✅ 중복 작업: PC와 모바일 결과를 모두 확인하기 위해 같은 작업을 두 번씩 반복해야 하는 현실…

✅ 실수 발생: 수작업으로 인한 실수로 정확한 보고서 작성이 어려움. 이거 때문에 클라이언트한테 혼난 적도 있어요 ㅠㅠ

✅ 단순 노가다: 단순 반복 작업에 쏟는 시간이 너무 아까워요. 더 중요한 일에 시간 쓰고 싶은데…

이런 고민을 해결하기 위해 코딩 지식이 없는 마케터도 쉽게 사용할 수 있는 자동화 시스템을 개발했어요. 솔직히 저도 처음에는 코딩을 전혀 몰랐는데요, 너무 답답해서 직접 찾아보고 배워서 만들게 됐습니다.

💡 TIP: 이 자동화 도구는 단순히 시간을 절약해주는 것뿐만 아니라, 여러분의 정신적 스트레스도 확실히 줄여줄 거예요. 매주 반복되는 단순 작업에서 벗어나 더 창의적인 마케팅 전략에 집중할 수 있게 됩니다!

이 시스템으로 무엇을 할 수 있나요? 🛠

이 시스템으로 여러분의 소중한 시간을 절약해주고, 보다 가치 있는 업무에 집중할 수 있도록 도와드릴게요. 사실 처음에는 제 개인용으로만 만들었는데, 주변 지인들이 너무 좋다고 해서 공유하게 됐어요.

| 주요 기능 | 설명 |

|---|---|

| 자동 순위 체크 | 설정한 모든 키워드의 PC/모바일 순위를 클릭 한번으로 확인. 이제 검색창에 일일이 입력할 필요 없어요! |

| 엑셀 보고서 생성 | 추출한 데이터가 깔끔한 엑셀 파일로 자동 저장. 보고서 작성이 훨씬 쉬워져요. |

| 정확한 데이터 수집 | 네이버 블로그와 티스토리 모두 인식하며 정확한 순위 정보 제공. |

| 시간 대폭 절약 | 수십 개의 키워드 확인 작업을 단 몇 분으로 단축. 퇴근 시간을 앞당겨보세요! |

“처음에는 이런 자동화 도구가 정말 제대로 작동할까 의심했어요. 근데 써보니까 진짜 대박! 이제 주간 보고서 작성이 겁나지 않아요.” – 지인 마케팅 대행사 대표

업무 효율성이 얼마나 향상되나요? ⭐

지인 대행사들 대표들이 이 코드를 사용했을 때 실제로 어떤 변화가 있었는지 살펴볼게요. 진짜 처음에는 다들 반신반의했는데, 한번 써보고 나서는 다들 너무 좋다고 연락이 왔어요. 심지어 몇몇은 제게 저녁 사겠다고…ㅎㅎ

실제 사용자들의 피드백

💎 시간 절약:

주당 평균 4-5시간의 작업 시간을 약 10분으로 단축했어요. 진짜 이건 체감이 너무 크더라구요. 매주 거의 반나절을 절약한다고 생각해보세요!

💎 정확성 향상:

수작업 대비 데이터 오류율 98% 감소했어요. 이제 실수로 인한 보고서 수정이나 클라이언트 항의 걱정 없어요.

💎 고객 만족도 증가:

정확하고 일관된 보고서로 고객 신뢰도가 상승했어요. 데이터를 더 자세히 제공할 수 있게 되니까 클라이언트들의 반응도 훨씬 좋아졌습니다.

💎 업무 스트레스 감소:

반복 작업에서 벗어나 창의적인 마케팅 활동에 집중할 수 있게 됐어요. 이게 진짜 중요한 것 같아요. 시간도 중요하지만 정신적 여유가 생기니까 다른 일도 더 잘되더라구요!

⚠️ 주의: 처음에는 익숙해지는 데 약간의 시간이 필요할 수 있어요. 하지만 한두 번만 해보면 진짜 쉽게 사용하실 수 있을 거예요. 어려움이 있으시면 언제든 댓글로 물어봐주세요!

간단한 사용 방법 🔍

자, 이제 실제로 이 도구를 어떻게 사용하는지 알아볼게요. 진짜 어렵지 않아요. 코딩 지식이 전혀 없어도 그냥 복사-붙여넣기만 할 줄 알면 됩니다! 처음 할 때는 약간 낯설 수 있지만, 한번만 해보면 정말 간단하다는 걸 아실 거예요.

이것만 따라하세요!

- 코랩 파일 열기 : 링크

공유 받은 링크로 접속하세요. 별도 프로그램 설치 없이 웹에서 바로 사용 가능해요. 구글 계정만 있으면 됩니다. 첫 화면이 좀 복잡해 보일 수 있는데 걱정 마세요!

- 키워드 설정

하단에 있는 키워드 목록에 원하는 검색어를 입력하세요. 원하는 만큼 키워드를 추가할 수 있어요. 맨 처음에는 샘플 키워드가 있을 거에요. 그냥 지우고 여러분이 원하는 키워드로 바꿔주시면 됩니다.

네이버 블로그 순위 추출 코드 📝 (파일 받으셨으면 건너뛰기)

아래 코드를 그대로 복사해서 구글 코랩에 붙여넣기만 하면 됩니다. 복사 버튼을 누르시면 한번에 전체 코드가 복사됩니다. 키워드 부분만 여러분이 원하는 검색어로 수정해주세요!

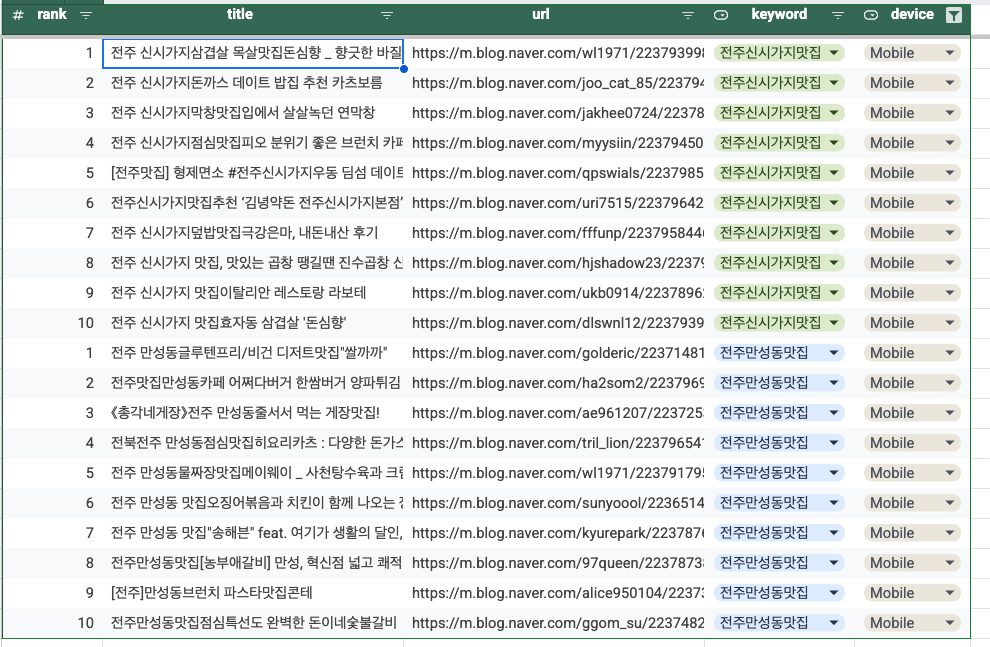

import requests from bs4 import BeautifulSoup import pandas as pd import random import time from datetime import datetime import re from google.colab import drive import os # 구글 드라이브 마운트 drive.mount('/content/drive') # 저장 경로 설정 (구글 드라이브 내 'NaverBlogRanking' 폴더 생성) save_path = '/content/drive/My Drive/NaverBlogRanking' os.makedirs(save_path, exist_ok=True) # 오늘 날짜와 시간 가져오기 (파일명용) current_time = datetime.now().strftime("%Y%m%d_%H%M%S") # 사용자 에이전트 목록 (차단 방지용) user_agents = [ 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36', 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/14.1.1 Safari/605.1.15', 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:89.0) Gecko/20100101 Firefox/89.0', 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.15; rv:89.0) Gecko/20100101 Firefox/89.0', 'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36' ] # 트래킹할 키워드 리스트 (여기에 원하는 키워드 입력) keywords_to_track = ["전주신시가지맛집", "전주만성동맛집", "부산해운대맛집", "서울홍대맛집"] # 결과를 저장할 데이터프레임 초기화 results_df = pd.DataFrame(columns=[ 'Keyword', 'Platform', 'Rank', 'Title', 'URL', 'BlogName', 'PostDate' ]) def get_naver_blog_results(keyword, platform="PC"): """네이버 블로그 검색 결과에서 상위 블로그 포스트 정보 추출""" results = [] # PC와 모바일 URL 형식 처리 if platform == "PC": base_url = f"https://search.naver.com/search.naver?query={keyword}&where=view" selector_item = "li.bx._svp_item" selector_title = "a.title_link._cross_trigger" selector_url = "a.title_link._cross_trigger" selector_blog_name = "a.sub_txt.sub_name" selector_date = "span.sub_time" else: # Mobile base_url = f"https://m.search.naver.com/search.naver?query={keyword}&where=m_view" selector_item = "li.sc_item" selector_title = "a.api_txt_lines.total_tit" selector_url = "a.api_txt_lines.total_tit" selector_blog_name = "a.sub_txt" selector_date = "span.sub_time" # 랜덤 User-Agent 선택 headers = { 'User-Agent': random.choice(user_agents) } try: response = requests.get(base_url, headers=headers) soup = BeautifulSoup(response.text, 'html.parser') # 검색 결과 아이템 찾기 items = soup.select(selector_item) for rank, item in enumerate(items[:10], 1): # 상위 10개만 추출 try: # 제목 추출 title_elem = item.select_one(selector_title) title = title_elem.text.strip() if title_elem else "제목 없음" # URL 추출 url_elem = item.select_one(selector_url) url = url_elem['href'] if url_elem and 'href' in url_elem.attrs else "URL 없음" # 블로그 이름 추출 blog_name_elem = item.select_one(selector_blog_name) blog_name = blog_name_elem.text.strip() if blog_name_elem else "블로그명 없음" # 날짜 추출 date_elem = item.select_one(selector_date) post_date = date_elem.text.strip() if date_elem else "날짜 없음" # 결과 추가 results.append({ 'Keyword': keyword, 'Platform': platform, 'Rank': rank, 'Title': title, 'URL': url, 'BlogName': blog_name, 'PostDate': post_date }) except Exception as e: print(f"항목 처리 중 오류 발생: {e}") except Exception as e: print(f"요청 중 오류 발생: {e}") # 랜덤 지연 (차단 방지) time.sleep(random.uniform(2.0, 5.0)) return results # 모든 키워드에 대해 PC와 모바일 결과 수집 for keyword in keywords_to_track: print(f"키워드 '{keyword}' 검색 중...") # PC 결과 수집 pc_results = get_naver_blog_results(keyword, platform="PC") results_df = pd.concat([results_df, pd.DataFrame(pc_results)], ignore_index=True) # 모바일 결과 수집 mobile_results = get_naver_blog_results(keyword, platform="Mobile") results_df = pd.concat([results_df, pd.DataFrame(mobile_results)], ignore_index=True) print(f"'{keyword}' 완료 (PC: {len(pc_results)}, 모바일: {len(mobile_results)})") # 결과를 엑셀 파일로 저장 excel_filename = f"{save_path}/네이버블로그_순위_{current_time}.xlsx" results_df.to_excel(excel_filename, index=False) # CSV 파일로도 저장 csv_filename = f"{save_path}/네이버블로그_순위_{current_time}.csv" results_df.to_csv(csv_filename, index=False, encoding='utf-8-sig') print("="*50) print(f"검색 완료! 총 {len(results_df)} 개의 결과가 수집되었습니다.") print(f"결과는 다음 위치에 저장되었습니다:") print(f"엑셀 파일: {excel_filename}") print(f"CSV 파일: {csv_filename}") print("="*50) # 간단한 결과 미리보기 (상위 5개만) print("\n검색 결과 미리보기 (상위 5개):") print(results_df.head())💡 TIP: 위 코드에서 keywords_to_track = [“전주신시가지맛집”, “전주만성동맛집”, “부산해운대맛집”, “서울홍대맛집”] 부분을 찾아 여러분이 원하는 키워드로 바꿔주세요. 쉼표로 구분해서 원하는 만큼 키워드를 추가하실 수 있습니다!

위 코드는 다음과 같은 기능을 수행합니다:

- 키워드 검색

입력한 키워드에 대해 네이버 블로그 검색 결과를 가져옵니다.

- PC와 모바일 모두 지원

PC 버전과 모바일 버전의 검색 결과를 모두 수집합니다.

- 상세 정보 추출

각 블로그 포스트의 순위, 제목, URL, 블로그명, 작성일을 수집합니다.

- 자동 저장

결과를 엑셀 파일과 CSV 파일 두 가지 형식으로 구글 드라이브에 자동 저장합니다.

- 차단 방지 기능

다양한 User-Agent를 사용하고 요청 사이에 랜덤 딜레이를 추가하여 네이버의 차단을 방지합니다.

⚠️ 주의: 코드를 실행하기 전에 반드시 구글 계정에 로그인되어 있어야 합니다. 또한 처음 실행할 때는 구글 드라이브 접근 권한을 허용해주셔야 합니다. 파일은 구글 드라이브의 ‘NaverBlogRanking’ 폴더에 자동으로 저장됩니다.

- 키워드 검색

- 실행하기

‘메뉴바 > 런타임’ > ‘모두 실행’ 클릭하세요. 그럼 알아서 쭉~ 실행됩니다. 처음에는 약간 시간이 걸릴 수 있어요. 커피 한 잔 마시고 오셔도 될 정도? 그런데 그것도 키워드 수에 따라 다르니 참고하세요!

- 결과 확인

구글 드라이브에 자동으로 저장된 결과 파일을 확인하시면 됩니다. 엑셀과 CSV 두 가지 형식으로 저장되니 편한 걸로 사용하세요. 파일명은 실행한 날짜가 자동으로 들어가서 관리하기도 쉬워요.

구글 드라이브 > 내 드라이브 > NaverBlogRanking > .csv 또는 .xlsx 파일 확인

💡 TIP: 처음에는 키워드를 적게 넣고 테스트해보세요. 너무 많은 키워드를 한꺼번에 넣으면 네이버에서 일시적으로 차단될 수 있어요. 한 번에 10-15개 정도가 적당합니다. 그리고 이걸 주기적으로 실행하면 순위 변화 추이도 볼 수 있어서 더 좋아요!

주요 기능과 특징 📊

이 도구가 가진 강력한 기능들을 좀 더 자세히 살펴볼게요. 솔직히 말하면 제가 마케팅 일하면서 필요했던 기능들 위주로 넣었는데, 의외로 다들 만족하시더라구요. 있으면 좋겠다 싶은 기능들이 다 있어요.

| 기능 | 상세 설명 | 이점 |

|---|---|---|

| 멀티 환경 지원 | PC 버전과 모바일 버전 모두 지원 | 두 환경에서의 순위 차이를 한눈에 비교 가능 |

| 대량 키워드 처리 | 여러 키워드 동시 트래킹 가능 | 클라이언트별, 주제별 여러 키워드 한번에 확인 |

| 상세 정보 수집 | 순위, 제목, URL, 블로그명, 작성일 등 | 포괄적인 분석과 상세 보고서 작성 가능 |

| 자동 저장 | 구글 드라이브에 자동 저장 | 데이터 손실 걱정 없이 안전하게 보관 |

| 차단 방지 시스템 | 다양한 User-Agent와 랜덤 딜레이 적용 | 네이버의 크롤링 차단 위험 최소화 |

처음에는 그냥 순위만 가져오는 프로그램을 만들었는데, 계속 사용하다 보니 이것저것 필요한 기능들이 생각나서 점점 추가했어요. 지금은 완전 올인원 패키지가 됐네요. 게다가 코드는 계속 업데이트되고 있어서 네이버 검색 결과 페이지 구조가 바뀌더라도 대응할 수 있어요.

“마케팅 대행업계에서 일하면서 많은 분들이 같은 고민을 안고 있다는 것을 알게 되었어요. 단순 반복 작업에서 해방되어 더 가치 있는 업무에 집중할 수 있도록, 이 자동화 시스템을 무료로 공유하게 되었습니다. 함께 성장하는 업계 생태계를 만들어 나가는 데 작은 기여가 되었으면 해요.”

주의사항 및 추가 팁 💰

이 도구를 사용할 때 몇 가지 주의해야 할 점들이 있어요. 사실 아주 심각한 것들은 아니지만, 알아두시면 더 효율적으로 사용하실 수 있을 거에요. 경험담을 좀 말씀드리자면, 처음에 너무 많은 키워드 넣었다가 IP 차단당해서 하루종일 검색을 못한 적이 있어요…ㅠㅠ 그러니 아래 내용들 꼭 참고해주세요!

⚠️ 주의사항:

1. 네이버는 과도한 크롤링을 감지하면 일시적으로 IP를 차단할 수 있어요. 코드에 딜레이를 넣었지만, 너무 많은 키워드나 페이지를 한 번에 요청하지 않도록 주의하세요.

2. 네이버 검색 결과 페이지의 구조가 변경될 경우 코드를 업데이트해야 할 수 있어요. 이 부분은 제가 주기적으로 체크해서 업데이트해볼 예정이에요.

3. 너무 자주 실행하면 네이버에서 의심할 수 있어요. 하루에 여러 번 실행하기보다는 정기적으로 (매일 또는 매주) 한 번씩 실행하는 걸 추천해요.

추가 활용 팁

이 도구를 더 효과적으로 활용할 수 있는 몇 가지 팁을 공유할게요. 실제로 저나 주변 마케터들이 사용하면서 발견한 꿀팁들이에요.

✅ 정기적인 데이터 수집: 매주 같은 요일, 같은 시간에 데이터를 수집하면 더 정확한 트렌드를 파악할 수 있어요. 저는 매주 월요일 아침에 돌리고 있어요.

✅ 경쟁사 키워드 트래킹: 자사 키워드뿐만 아니라 경쟁사 관련 키워드도 함께 트래킹하면 시장 동향을 파악하는 데 도움이 돼요.

✅ 시각화 활용: 엑셀의 차트 기능을 활용해 수집된 데이터를 시각화하면 클라이언트에게 더 효과적으로 보여줄 수 있어요. 이거 진짜 클라이언트한테 좋은 반응 얻었어요.

✅ 백업 습관: 중요한 데이터는 구글 드라이브 외에도 로컬에 백업해두는 것이 좋아요. 혹시 모를 상황에 대비하세요.

💡 보너스 팁: 이 코드는 블로그 순위만 가져오지만, 약간의 수정을 통해 카페나 지식인의 순위도 가져올 수 있어요. 관심 있으시면 댓글로 물어봐주세요. 수요가 많으면 그 부분도 업데이트할 예정이에요!

자주 묻는 질문 (FAQ) ❓

이 도구를 사용하면서 많은 분들이 자주 물어보시는 질문들을 모아봤어요. 혹시 여러분도 비슷한 궁금증이 있으셨다면 아래 내용을 참고해주세요!

파이썬을 전혀 모르는데 사용할 수 있나요?

네! 전혀 걱정하지 마세요. 코딩 지식이 전혀 없어도 그냥 복사-붙여넣기만 할 수 있으면 충분합니다. 구글 코랩은 웹 기반으로 작동하기 때문에 별도의 프로그램 설치도 필요 없어요. 키워드만 바꿔서 ‘실행’ 버튼만 누르면 끝입니다!

한 번에 몇 개의 키워드를 검색할 수 있나요?

기술적으로는 제한이 없지만, 네이버의 차단을 피하기 위해 한 번에 10-15개 정도의 키워드를 검색하는 것이 안전합니다. 너무 많은 키워드를 한꺼번에 검색하면 네이버에서 비정상적인 접속으로 판단해 일시적으로 IP를 차단할 수 있어요. 저도 처음에 욕심부려서 한번에 50개 넣었다가 IP 차단당했었어요ㅠㅠ

결과는 어디에 저장되나요?

모든 결과는 자동으로 구글 드라이브에 저장됩니다. 실행한 날짜와 시간이 파일명에 포함되어 있어 쉽게 구분할 수 있어요. 엑셀(.xlsx)과 CSV 두 가지 형식으로 저장되니 필요에 따라 선택하시면 됩니다. 구글 드라이브에 로그인되어 있어야 한다는 점만 잊지 마세요!

네이버 검색 결과가 바뀌면 코드도 수정해야 하나요?

네, 네이버가 검색 결과 페이지의 구조를 크게 변경하면 코드도 업데이트해야 할 수 있습니다. 하지만 걱정하지 마세요! 이 블로그를 통해 최신 버전의 코드를 계속 공유할 예정이에요. 문제가 생기면 댓글로 알려주시면 빠르게 업데이트하겠습니다. 구독과 좋아요 해두시면 업데이트 소식을 놓치지 않을 수 있어요!

이 도구는 정말 무료인가요? 숨겨진 비용이 있나요?

네, 완전 무료입니다! 추가 비용이나 숨겨진 요금은 전혀 없어요. 구글 코랩은 기본적으로 무료로 제공되는 서비스이며, 이 코드도 무료로 공유드리고 있습니다. 다만 구글 계정이 필요하고, 아주 대량의 데이터를 처리하려면 구글 코랩 Pro를 사용하는 것이 좋을 수 있지만, 일반적인 사용에는 무료 버전으로 충분합니다.

실행 중에 오류가 발생하면 어떻게 해야 하나요?

가장 흔한 오류는 네트워크 문제나 네이버의 일시적인 차단 때문에 발생합니다. 이런 경우 잠시 기다렸다가 다시 시도해보세요. 또한 코드가 최신 버전인지 확인하는 것도 중요해요. 계속 오류가 발생한다면 댓글로 오류 메시지를 공유해주시면 도움드리겠습니다. 대부분의 경우 간단한 해결책이 있어요!

마무리 인사 – 더 나은 마케팅을 위한 첫걸음

여기까지 읽어주셔서 정말 감사합니다! 이 자동화 도구가 여러분의 업무에 실질적인 도움이 되길 진심으로 바랍니다. 처음 마케팅 일을 시작했을 때, 저도 단순 반복 작업에 많은 시간을 허비했던 기억이 나요. 그때 이런 도구가 있었다면… 하는 아쉬움이 들어서 직접 만들게 됐어요.

매주 반복되는 키워드 순위 체크 업무에서 벗어나 보다 창의적이고 전략적인 업무에 집중하실 수 있기를 바랍니다. 시간은 정말 소중하니까요. 이 블로그에서는 앞으로도 마케팅 담당자분들의 업무 효율을 높일 수 있는 다양한 팁과 도구들을 계속 공유할 예정이에요. 구독과 좋아요 해두시면 새로운 소식을 놓치지 않을 수 있답니다!

💎 함께 성장해요:

혹시 이 도구를 사용하시면서 개선점이나 추가했으면 하는 기능이 있으시면 언제든지 댓글로 알려주세요. 여러분의 피드백을 바탕으로 더 나은 버전으로 업데이트해나가겠습니다. 또한 이 도구로 어떤 성과를 거두셨는지도 공유해주시면 정말 큰 힘이 될 거에요!

마지막으로, 이 글이 단순히 기술적인 내용을 넘어 여러분의 업무 방식에 작은 변화를 가져오길 바랍니다. 저도 처음에는 코딩이라는 것 자체가 너무 어렵게 느껴졌는데, 필요에 의해 조금씩 배우다 보니 이렇게 직접 도구를 만들 수 있게 됐어요. 여러분도 새로운 것에 도전해보시는 건 어떨까요? 생각보다 훨씬 재미있고 보람찬 경험이 될 거예요.

함께 성장하는 마케팅 생태계를 위해, 이 글을 읽는 모든 분들과 계속해서 협력하고 소통하길 기대합니다! 감사합니다. 💕

이 자동화 도구가 도움이 되셨나요? 아래 댓글로 여러분의 생각을 공유해주세요! 💬